Progetto LIS4.0: intervista a Stefano Melzi, professore DMEC coinvolto nel WP4 - Sistemi Autonomi

Di cosa si occupa il WP4 nell’ambito del LIS4.0? Quali sono le principali sfide che affronta?

Il WP4 di LIS4.0 è incentrato sullo sviluppo e applicazione di tecnologie innovative per la mobilità sostenibile delle persone. In particolare, la ricerca si propone di progettare sistemi per la guida assistita (ADAS) e per la guida autonoma connessa, attraverso lo sviluppo di algoritmi di automazione e la creazione di un sistema di comunicazione tra veicoli e infrastruttura (V2X). Parallelamente, il WP4 analizza e verifica l’impatto di tecnologie innovative impiegate per la realizzazione dei veicoli, valutando l’introduzione di materiali con un migliore rapporto tra peso e resistenza e maggiori capacità di assorbimento di energia. Tutte le attività del WP4 sono svolte tenendo sempre presente il ruolo centrale della persona che si traduce nell’attenzione al comfort e allo sviluppo di interfacce HMI.

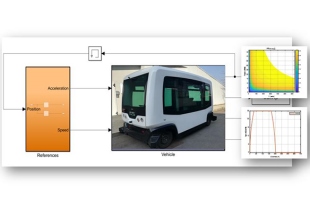

Le attività del WP4 gravitano attorno ad un veicolo dimostratore: si tratta di un pullmino elettrico a zero emissioni per il trasporto di una decina di persone che stiamo trasformando in uno shuttle urbano a guida autonoma. Gli obiettivi del progetto sono numerosi e ambiziosi e ci troviamo di fronte a diverse sfide: innanzitutto stiamo sviluppando l’architettura di controllo del veicolo per implementare logiche che portino ad una progressiva automatizzazione delle operazioni di guida del veicolo, comprensive di feature basate sulla connettività V2X. In secondo luogo, abbiamo sviluppato e stiamo implementando modelli matematici per valutare l’effetto dell’installazione di componenti alleggeriti su prestazioni e autonomia e l’impatto di materiali ad alto assorbimento di energia di deformazione sulla sicurezza passiva. Infine, stiamo costruendo un’interfaccia uomo-macchina innovativa che consenta agli utenti di maturare fiducia nel sistema di guida autonomo attraverso la condivisione delle informazioni che esso impiega per guidare il veicolo e la comunicazione delle azioni che intraprenderà negli istanti successivi.

Quali soluzioni di comunicazione/connettività e localizzazione sono necessarie a supporto delle logiche di controllo di un sistema veicolare autonomo?

Questa domanda non ha una risposta semplice: in ambito industriale ed accademico esistono differenti visioni e linee di pensiero in merito. Infatti vi sono gruppi di ricerca e aziende che lavorano su sistemi di localizzazione basati principalmente sul solo utilizzo delle telecamere (principalmente per limitare I costi) mentre altri utilizzano una ridondanza di sensori oltre alle telecamere (dai lidar, ai radar, agli ultrasuoni) processando molti più dati ed eseguendo sensor-fusion per ottenere risultati più robusti. Dal punto di vista della connettività la comunità scientifica ed industrial si divide nuovamente in gruppi di ricerca che sostengono come la connettività V2I e V2V ad alta velocità ed affidabilità, ottenuta ad esempio tramite il 5G, sia essenziale per raggiungere I più alti livelli di automazione in sicurezza, mentre altri sostengono che il singolo veicolo debba essere completamente autosufficiente come il pilota umano per limitare il più possibile rischi di cybersecurity. Il nostro prototipo presenta in questo senso una moltitudine di sensori ridondati e la possibilità di ricevere ed inviare informazioni proprio allo scopo di comparare e valutare le diverse soluzioni implementative.

Per un’integrazione il più possibile naturale ed immediata con gli utilizzatori del veicolo e gli utenti esterni, oltre che per migliorare gli aspetti di sicurezza, quali aspetti di interazione uomo-macchina avete investigato?

L’interazione con un veicolo autonomo per il trasporto pubblico pone diversi interrogativi circa la possibilità da parte degli utenti di richiedere informazioni e di poter impartire istruzioni di controllo. Mentre in un veicolo tradizionale queste attività sono spesso delegate al conducente, in questo caso la sua assenza potrebbe creare disagi e soprattutto risultare pericolosa in caso di emergenza. Bisogna inoltre tener presente che gli utenti di un mezzo pubblico possono avere diverse esigenze e richiedere supporto specifico.

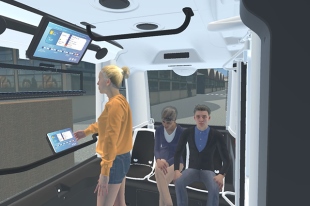

Per questo motivo è stato necessario sviluppare un’interfaccia che potesse supportare le esigenze di utenti eterogenei e questo ha richiesto l’implementazione di un sistema di interazione che stimoli diversi aspetti sensoriali dell’essere umano. Il sistema sviluppato sfrutta principalmente i canali di comunicazione audio video ed integra un dispositivo di interazione senza contatto con feedback tattile ad ultrasuoni che, tramite il riconoscimento di specifici gesti delle mani, abilita diverse funzionalità del mezzo. Oltre all’interazione all’interno del veicolo si sono analizzate diverse modalità di comunicazione verso l’esterno. È fondamentale, infatti, che il veicolo possa dare chiara evidenza delle proprie intenzioni di manovra e allertare gli utenti in caso di pericolo. In questo caso si è scelto di sfruttare i dispositivi attualmente installati sul mezzo codificandone opportunamente il comportamento.

Come avete combinato, nei vostri studi, le attività sperimentali in campo con gli sviluppi in ambiente simulato?

Le tre macro-attività del WP4 seguono percorsi differenti legati in parte alle loro particolarità e in parte alla situazione sanitaria 2020 che ha spinto ad anticipare alcune attività numeriche rispetto a quelle sperimentali. L’attività relativa all’impiego di tecnologie innovative nel veicolo dimostratore viene svolta quasi esclusivamente per via numerica: è stato sviluppato un modello modulare dello shuttle, comprensivo di motore elettrico, batterie e logica di controllo della velocità per prevedere l’autonomia del veicolo in funzione della massa complessiva e della sua missione, definita in termini di distanza tra le fermate e profilo di velocità tra le stesse. Le altre due attività hanno come naturale obiettivo la realizzazione del veicolo dimostratore con tutte le funzionalità previste. L’architettura di controllo del pullmino è stata definita e testata in ambiente simulato. Sono stati condotti test per acquisire i segnali dai sensori installati sul veicolo (telecamera, lidar, GPS) integrando le informazioni degli stessi per ricostruire l’ambiente in cui questo si muove. Al momento stiamo realizzando una rete semaforica portatile che useremo sul campo per testare la comunicazione del veicolo con l’infrastruttura. Per quanto concerne invece l’interfaccia uomo macchina, l’intero sistema di interazione è stato implementato e validato in ambiente di realtà virtuale. Questo ha permesso di esplorare diverse soluzioni tecniche al fine di identificare quella più adatta per l’implementazione sul dimostratore fisico. Il sistema di interazione così sviluppato verrà implementato nei prossimi mesi sul veicolo per una successiva validazione sul campo.

Quali sono i principali risultati dei vostri studi sulle logiche di guida autonoma che avete integrato nella piattaforma sperimentale costituita dal dimostratore del progetto LIS4.0?

Allo stato attuale abbiamo lavorato alla definizione di una architettura informatica modulare per l’acquisizione delle informazioni provenienti da tutti i sensori presenti sul veicolo prototipale e che ne riporti i risultati in un sistema di riferimento comune fissato con il frame del veicolo. Tale architettura permette ai diversi sistemi di elaborazioni montati sul veicolo di poter accedere alle informazioni in ogni momento ed elaborarle secondo necessità. È stata inoltre realizzata una modalità di comunicazione digitale tra pc di controllo e sistema PLC montato sul veicolo per consentire la movimentazione del mezzo mediante una comunicazione bidirezionale CAN. È invece in via di sviluppo la realizzazione di un sistema di comunicazione tra l’architettura del prototipo ed una infrastruttura esterna mediante rete mobile (attualmente 4G) allo scopo di rendere disponibili informazioni dall’ambiente (es. semafori) all’interno del veicolo. L’adattamento delle logiche di controllo progettate in simulazione alla piattaforma del veicolo sono in corso: esse consentiranno di percepire l’ambiente circostante, decidere le azioni da compiere e inviare gli input di controllo al sistema di attuazione.